ACTUALITE INTERNATIONALE de L'ENVIRONNEMENT

2007

novembre

| LE

MONDE | 24.10.07

Le premier ministre, François Fillon, et le ministre de l'écologie, Jean-Louis Borloo, ont ouvert, mercredi 24 octobre, la table-ronde finale du Grenelle de l'environnement, qui doit durer deux jours. A l'ouverture des débats, M. Borloo a annoncé au journal Le Monde la décision d'arrêter la construction d'autoroutes (sauf les contournements de villes) et le lancement d'un programme d'isolation de l'habitat financé à hauteur de 20 milliards d'euros par l'Etat. Dans le document qui sert de trame à la table-ronde finale, publié par Le Monde.fr le 17 octobre, Jean-Louis Borloo avait déjà annoncé un changement de "paradigme", afin que "la route et l'avion deviennent des solutions de dernier recours": "La rupture s'impose. Il s'agit d'un changement radical d'approche, passant du principe du rattrapage autoroutier à un développement à grande échelle des transports alternatifs (...). |

Le paradigme actuel, fondé sur la priorité accordée

aux infrastructures routières et autoroutières et sur le

développement séparé des modes de transport, doit

laisser place à une logique de développement intégrée,

multimodale, dans laquelle la route et l'avion deviennent des solutions

de dernier recours imposées par l'état des technologies ou

la géographie. La capacité routière globale du pays

ne doit plus augmenter, sauf pour éliminer des points de congestion

et des problèmes de sécurité. Il s'agit aussi de réduire

l'intensité énergétique des transports. L'objectif

retenu est de réduire de 20% d'ici à 2020 les émissions

actuelles [de gaz à effet de serre]."

A l'issue de ces deux journées de négociations entre les représentants de l'Etat, des ONG écologistes, du patronat, des syndicats et des collectivités locales, Nicolas Sarkozy annoncera des mesures retenues pour réorienter la politique écologique de la France. Il recevra à cette occasion le président de la Commission européenne, José Manuel Barroso, et deux Prix Nobel de la paix, l'Américain Al Gore et la Kényane Wangari Maathai. |

| Il faut espérer que le

Prix Nobel attribué à Al Gore et au GIEC contribuera à

dépasser les bonnes intentions, notamment dans le financement de

la formation: car on commence à manquer de spécialistes dans

les domaines scientifiques permettant d'aborder les problèmes climatiques.

Comme souvent lorsqu'il s'agit du Prix Nobel de la paix, il y a à la clé un message politique ou social fort, comme par exemple le Nobel attribué à Aung San Suu Kyi en Birmanie en hommage à sa lutte pour la démocratie. Dans le cas du double prix de cette année, il est totalement réjouissant de voir que le domaine climat, fort médiatisé depuis quelque temps, reçoit un sacre prestigieux, à la fois par l'intermédiaire d'Al Gore (l'un des «porte-parole» du changement climatique le plus écouté), mais aussi et surtout par le biais de l'IPCC (Intergovernmental Panel on Climate Change), en français GIEC (Groupe intergouvernemental pour l'étude de l'évolution du climat). Comme l'a rappelé le président en exercice du GIEC, Rajendra Pachauri, ce prix récompense l'engagement de nombreux scientifiques (auteurs contribuant aux rapports de l'IPCC et membres des organes administratifs) depuis 1988, date de la création de l'IPCC par ses deux autorités onusiennes de tutelle, l'Organisation météorologique mondiale (OMM à Genève) et le Programme des Nations unies pour l'environnement (PNUE à Nairobi). Il est intéressant de voir que c'est le Nobel de la paix qui consacre les travaux des chercheurs, car vu les enjeux scientifiques, économiques et politiques du réchauffement climatique, l'IPCC aurait pu aussi recevoir le Nobel de physique, de chimie ou d'économie. Mais vu aussi le potentiel de conflits internes, transfrontaliers ou régionaux associés à un réchauffement rapide en bien des régions du monde - réfugiés liés à la montée des océans, pertes de ressources en eau, problèmes de sécurité alimentaire - le Nobel de la paix admet que les problèmes climatiques vont exacerber des situations sociales et économiques déjà délicates aujourd'hui. En mettant une fois pour toutes les hésitants et les sceptiques en marge du débat scientifique (déjà mis à mal ces derniers temps par une avalanche d'informations confirmant la thèse du réchauffement), le Nobel de la paix 2007 plaide indirectement pour la mise en œuvre sans attendre de stratégies s'attaquant au problème, car moins le réchauffement sera important ces prochaines décennies, moins les risques associés seront grands. Et par conséquent plus faible sera le potentiel de conflits ou de migrations. Dans les faits, le message sous-jacent lié à l'attribution du Prix Nobel de la paix 2007 sera-t-il entendu? Si l'on prend l'exemple du Nobel d'Aung San Suu Kyi déjà mentionné, on peut en douter, car au-delà d'une certaine médiatisation passagère et épisodique de la misère du peuple birman, aucune mesure sérieuse n'a été prise au niveau politique pour mettre fin à ce problème. On pourrait espérer, à l'instar de quelques commentaires qui ont suivi l'attribution du Nobel, que celui-ci puisse stimuler la prise de décisions rapides, efficaces et contraignantes pour l'après-Kyoto, dont la première phase se termine en 2012. Il est probable alors que peu de pays auront atteint les objectifs de réductions de 5 à 8% des émissions de gaz à effet de serre par rapport à l'année de référence de 1990. Mais quand l'on voit en Suisse, par exemple, l'incapacité du monde politique à prendre des décisions pourtant simples pour interdire la fumée dans les lieux publics, on peut douter de ses capacités à aborder un sujet autrement plus complexe où les solutions sont loin d'être évidentes! Dans le cas de la fumée, on dispose d'un dossier scientifique clair depuis cinquante ans sur les liens directs entre fumée et diverses maladies dont le cancer du poumon, et depuis plus de vingt ans sur les dangers de la fumée passive. Et pourtant on tergiverse au nom de la «liberté individuelle» (celle de rendre malade les non-fumeurs?), alors qu'une simple interdiction réglerait le problème... |

Pour ce qui est du dossier du changement climatique,

il a fallu attendre près d'une génération pour que

la réalité du problème soit acceptée jusque

dans les milieux politiques et économiques. On pourrait espérer

ne pas avoir à attendre une génération ou plus encore

avant de voir des décisions sérieuses se mettre en place

à temps pour éviter d'ici à 2050 l'irréversibilité

de certains dégâts liés au réchauffement climatique.

Mais quelles décisions prendre? Même si on sait aujourd'hui que près de 80% des émissions de gaz à effet de serre proviennent du secteur des carburants fossiles, on sait aussi que leur remplacement rapide par d'autres sources d'énergie avec, en parallèle, une plus grande efficacité énergétique, n'est pas aisé. De plus, les géants économiques que deviennent la Chine, l'Inde et aussi le Brésil, compliquent la donne car leurs industries sont alimentées par le charbon, et les pays du Nord seraient mal venus de se poser en donneurs de leçons auprès de ces nouveaux venus sur la scène internationale des émissions de carbone. Les déclarations politiques, certes encourageantes, comme celle de l'Union européenne, qui vise à réduire de 50% les émissions de gaz à effet de serre d'ici à 2050, ou de la Californie dont les objectifs sont encore plus draconiens, resteront lettre morte s'il n'y a pas concertation de tous les acteurs: secteurs industriels public et privé, énergie, transports, agriculture et bien entendu aussi le citoyen en tant qu'individu. Les efforts consentis devront passer par des incitations fiscales et des taxes, la mise en œuvre des technologies existantes et le développement de nouvelles technologies accessibles aux pays émergents, etc. Pour l'instant, au-delà des déclarations de bonnes intentions, on est encore loin de voir des décisions politiques sérieuses permettant de donner l'impulsion nécessaire à une ébauche de solutions durables au problème climatique. Car combattre le réchauffement climatique n'est pas synonyme de retour à l'âge de la pierre avec la perte des acquis de nos sociétés. De bonnes décisions politiques et économiques pourraient générer de nombreuses opportunités pour l'économie, notamment par le développement de technologies en phase avec les besoins urgents de la planète. Et ces progrès pourraient servir à réduire le clivage entre riches et pauvres et donc réduire le potentiel de conflits. Il y a aussi un autre problème de taille, surtout dans nos pays industrialisés: on commence à manquer de spécialistes dans les domaines scientifiques permettant d'aborder les problèmes climatiques. La bonne volonté et l'esprit écologique ne suffisent pas à régler ces problèmes complexes, multisectoriels et pluridisciplinaires. Pour aborder les questions climatiques, leurs impacts environnementaux et socio-économiques, ainsi que leurs solutions technologiques, on a besoin de la collaboration de physiciens, chimistes, biologistes, mathématiciens, informaticiens, économistes, politologues et sociologues. Or, on constate depuis plus de vingt ans un désintérêt croissant pour les sciences fondamentales, celles-là même qui sont essentielles à notre compréhension de systèmes complexes comme le climat et aux solutions technologiques à mettre en œuvre. Sont en cause les coupures budgétaires infligées aux milieux académiques, les restructurations des programmes des écoles secondaires faites au détriment d'une formation adéquate pour aborder un cursus universitaire scientifique. Et même si aujourd'hui on revient sur certaines décisions prises il y a dix ou quinze ans, il faudra encore une génération pour espérer retrouver un engouement pour les sciences fondamentales. Ou l'attribution de ce Nobel providentiel permettra-t-elle de renverser un peu plus rapidement la tendance? |

| Comment peut-on affirmer dans

le rapport du Grenelle: «Il faut changer la donne, imaginer un

modèle de développement radicalement différent, diviser

par quatre les gaz à effet de serre avant 2050» pour lutter

contre un réchauffement climatique qui pourrait atteindre 6°C

dans le siècle, et simplement conseiller de rouler plus lentement,

de ne plus manger de fraises en hiver ou de se laver les dents en économisant

l'eau, comme nous y encourage Jean-louis Borloo? Comment ne pas percevoir

le décalage entre un discours à juste

titre catastrophiste sur des menaces sans précédent pour

la planète, la biodiversité, la santé ou la qualité

de vie de chacun, et les solutions pusillanimes préconisées

par ailleurs, qui écartent comme une évidence de nouvelles

taxes et de réelles régulations du marché?

Dans le diagnostic, chacun peut se retrouver dans les conclusions des ateliers du Grenelle. Mais conseiller de prendre le tram ne sert à rien s'il n'est disponible que quelques centaines de kilomètres au niveau national à comparer à des centaines de milliers de kilomètres d'axes routiers urbains, surtout si les subventions de l'Etat sont supprimées depuis deux ans. A quoi bon encourager à prendre les bus alors que les réseaux en site propre ne sont plus financés par l'Etat dans les contrats de plan signés en 2007? Et encourager le fret ferré est sans conséquence si sa diminution rapide (4% par an et moins de 3% du total de trafic de marchandises) est favorisée par l'Etat, premier actionnaire de la SNCF, qui laisse celle-ci annoncer la suppression de près de 300 plate-formes régionales durant ce même Grenelle. Il n'est plus temps d'évaluer l'impact de telle ou telle nouvelle liaison routière, de créer un observatoire des transports, ou d'étiqueter les produits énergivores. L'heure n'est plus à l'exercice d'analyse et de recherche des bons indicateurs. |

L'heure est à l'action, quitte à

fâcher les lobbies et fortement taxer les gros pollueurs, quitte

à créer une taxe carbone à un niveau suffisant pour

décourager les transports de confort comme le granit importé

de Chine, pour financer les économies d'énergie. Et l'Etat

a également toute possibilité de financer uniquement les

logements desservis par des transports en commun, sachant qu'il intervient

directement ou indirectement dans 40% de la production de logements. Cette

synthèse fourmille néanmoins de bonnes idées, mais

rarement chiffrées et accompagnées de calendrier d'application.

Ainsi, construire une trame verte nationale est une bonne idée,

mais non pour préserver 10% du territoire national de l'urbanisation

et continuer à étaler l'urbanisation à raison de 1.000

km² par an, mais pour préserver 90% du territoire de l'urbanisation

et ainsi faire que la France ne soit plus le cinquième pays au monde

pour le nombre d'espèces menacées et le dernier en Europe

à créer un réseau Natura 2000, et encore sous la menace

de sanctions. De même, la formation des artisans aux bonnes pratiques

en termes d'isolation des bâtiments est une bonne chose, mais ne

serait il pas plus opportun encore de dégager des budgets pour l'isolation

des bâtiments anciens et non de continuer à diminuer les crédits

de l'Agence de l'environnement et de la maîtrise de l'énergie

(Ademe) sachant que le parc de logements en France se renouvelle uniquement

à raison de 1% par an, reportant ainsi de plus d'un siècle,

au rythme actuel, toute ambition globale d'économie d'énergie

dans le logement ?

Et nous pourrions multiplier de tels exemples. Faisons que le Grenelle de l'environnement ne soit pas un abus de langage, une idée généreuse lessivée par des communicants trop heureux de pouvoir bientôt réutiliser le label pour l'insertion, et peut être un jour pour la communication politique… Auteur de Ville libérale, ville durable?, aux éditions de l'Aube. |

| The prize could spur change in

the energy industry that coal, oil, natural gas and nuclear power dominate.

"It's a quiet revolution," said Sarah Emerson, the managing director

of Boston-Based Energy Security Analysis Inc, which has advised clients

about fossil fuels for decades. "Gore's winning makes it a little louder."

Gore's Oscar-winning movie "An Inconvenient Truth" and book of the

same name, and the UN Intergovernmental Panel on Climate Change's report

this year outlined global warming's threat and blamed it on gases emerging

from the smokestacks and tailpipes of the world's hydrocarbon economy.

They also highlighted that the comparatively tiny industries of biofuels,

wind and solar power, and energy-sipping compact florescent lightbulbs,

could over the coming decades help limit output of heat-trapping gases

belched out by fossil fuels. The technologies have a long road

ahead of them before they would help slow and then reverse output of greenhouse

gases. The two largest emitters of heat-trapping gases, the United States

and China, have plans to build hundreds of power plants that run on coal,

the heaviest emitter of carbon dioxide, the main greenhouse gas.

BUILDING THE NEW ENERGY ECONOMY "Gore has helped a whole lot of people see how critically important it is we address the climate crisis," Ted Nordhaus, an adviser to environmental groups, said in an interview. "Where we and he need to go next is to define an agenda that is focused on building the new energy economy, not just tearing down the old energy economy," said Nordhaus, the co-author of "Break Through," a book about how the world should fight global warming. |

In the United States, the world's top energy

consumer, renewables only generated 3 percent of electricity in July, according

to the US Energy Information Administration.

But wind and solar power are growing at about 30% or more every year. And US capacity to make ethanol has grown 28% this year. Global investment in renewable energies jumped to a record US$100 billion in 2006, and will likely rise to about US$120 billion in 2007, the UN Environment Program said this summer. Still, many of the technologies may suffer bumps on the road to development. Solar power may be hurt by low supplies of refined silicon and the US ethanol industry has transportation bottlenecks that could lead to a glut in the heart of the country and thin supply on the coasts. Fortunately for Gore and the IPCC, the peace prize comes during a time of record prices for oil, cheap supplies of which are harder and harder for major oil companies to find. Oil hit a record high above US$84 per barrel Friday amid supply concerns ahead of the Northern Hemisphere winter and tensions between northern Iraq and Turkey. Adam Bergman, a clean technology investment banker at Jeffries in New York, said the peace prize and record oil prices should push the US public to vote for politicians that would regulate greenhouse gases and provide strong incentives for renewables. He said incentives have helped put renewables on a level playing field with fossil fuels in European countries such as Germany and Spain. "US investors have put a lot of money in clean technologies ... but we don't have the incentive structures in place to make them competitive with traditional fossil fuels right now," he said. |

| Le comité du prix Nobel

a souhaité mettre à l'honneur Al Gore et le GIEC pour leur

effort de collecte et de diffusion des connaissances sur le réchauffement

climatique. À la veille de la conférence de Bali, la symbolique

est particulièrement forte !

L'ancien vice-président démocrate américain Al Gore et le GIEC (Groupe d'experts intergouvernemental sur l'évolution du climat) se partagent le prix Nobel de la paix 2007 ! Le prix leur est conjointement décerné pour leurs efforts de collecte et de diffusion des connaissances sur les changements climatiques provoqués par l'homme et pour avoir posé les fondements pour les mesures nécessaires à la lutte contre ces changements, a déclaré à Oslo le président du comité Nobel norvégien, Ole Danbolt Mjoes. Gageons qu'à la veille de la conférence de Bali, le comité norvégien du prix Nobel a souhaité marquer les esprits en mettant à l'honneur des personnalités qui éveillent les consciences sur le risque climatique. Le prix Nobel de la paix récompense la personnalité ayant le plus ou le mieux contribué au rapprochement des peuples, à la suppression ou à la réduction des armées permanentes, à la réunion et à la propagation des progrès pour la paix, selon les volontés d'Alfred Nobel. Cela comprend la lutte pour la paix, les droits de l'homme, l'aide humanitaire, la liberté. Partagé entre deux, voire trois personnalités ou institutions, il a été attribué pour la première fois en 1901. Comme l'avait décidé Alfred Nobel, les lauréats du prix Nobel de la paix sont choisis par un comité nommé par le parlement norvégien, les autres prix Nobel sont sélectionnés par l'Institution académique suédoise. 181 candidats étaient en lice pour cette année. Engagé dans le combat environnemental, Al Gore a notamment réalisé Une Vérité qui dérange. Le documentaire qui aborde techniquement et scientifiquement les menaces qui pèsent sur le climat a de plus reçu l'Oscar du meilleur documentaire 2007. |

Sorti en salle le 11 octobre en France, jour de la journée internationale

pour la prévention des catastrophes, ce film réalisé

par David Guggenheim tord le cou aux propos visant à semer le trouble

sur le réalisme du changement climatique. Rappelons que, Vice-président

des Etats-Unis sous l'administration Clinton qui avait signé le

protocole de Kyoto (accord qui n'a toutefois jamais été ratifié

par le Sénat américain ni même soumis aux Congrès),

Al Gore a décidé de s'investir personnellement sur la thématique

du réchauffement climatique à la suite de sa défaite

à l'élection de 2000. Depuis cinq ans, l'ex Vice-président

américain sillonne les États-Unis, multipliant conférences

et exposés pour convaincre ses concitoyens de la réalité

scientifique du réchauffement climatique et de l'urgence à

agir pour réduire les émissions de gaz à effet de

serre.

Le Groupe intergouvernemental d'experts sur l'évolution du climat (Giec) présidé par l'Indien Rajendra Pachauri a quant à lui publié cette année trois rapports d'évaluation qui comprennent plusieurs volumes et fournissent des informations scientifiques, techniques et socio-économiques sur les changements climatiques, leurs causes, leurs incidences et les mesures qui pourraient être prises pour y faire face. Une synthèse de l'ensemble sera faite dans le cadre d'une réunion plénière, à Valence en Espagne, du 12 au 16 novembre prochain. L'ensemble des travaux livrera les derniers enseignements scientifiques concernant le changement climatique. Créé en 1988 à la demande du G7, le GIEC a été mis en place par l'OMM (Organisation Météorologique Mondiale) et le Programme des Nations Unies pour l'environnement (PNUE). Le Nobel, un diplôme, une médaille d'or et un chèque de 1,08 million d'euros leur sera remis à Oslo le 10 décembre, date anniversaire de la mort de son fondateur. L'année dernière, c'est Muhammad Yunus (Bangladesh) ainsi que la banque Grameen Bank qui s'etait partagé ce prix prestigieux suite à leur participation au développement important du principe du micro-crédit. C.SEGHIER

|

| Mercredi, un mur végétal

dépolluant a été installé sur les façades

du parking du centre d'échange de la gare Lyon-Perrache. Selon la

mairie, il s'agit d'une "première mondiale".

Ce mur végétal, d'une surface de 400 m2, agit par "bio-filtration bactérienne". Il "devrait permettre de filtrer 650.000 m3 d'air pollué, prélevé dans le parking de la gare", a expliqué lors d'une conférence de presse Pascal Peleszezak, président directeur général de la société lyonnaise Canevaflor qui a conçu le mur végétal. "Ce n'est pas une simple tapisserie végétale comme la plupart des murs végétalisés. (…) Ce mur a un intérêt écologique en dépolluant l'air, mais également thermique car il isole le bâtiment des variations de température et enfin un intérêt phonique", a-t-il expliqué. "Des tuyaux d'air circulent dans le mur. L'air est aspiré à la sortie des bouches d'aération du parking et pulsé dans la terre où se trouvent des bactéries qui dégradent les polluants", a-t-il ajouté. Ainsi, au lieu d'être rejeté dans l'atmosphère, cet air sera injecté dans la terre des plantes qui composent le mur. Ces dernières se chargeront d'absorber les composants polluants. |

Test pouvant être étendu à 2.000 m2

Régulièrement, des vérifications seront réalisées afin de confirmer les essais réalisés en laboratoire. Selon une étude expérimentale, réalisée par Canevaflor, en collaboration avec l'Université de Savoie, les bactéries élimineraient 80% des composés organiques volatils (comme le benzène, le toluène, l'éthylbenzène et le xylène), et 50% du dioxyde de souffre et du dioxyde d'azote. Le mur a été installé à titre expérimental par le Grand Lyon et pourrrait être étendu à d'autres bâtiments si les résultats sont concluants. "Ce mur répond à un double enjeu, la pollution de l'air mais aussi le réchauffement climatique", a indiqué Gilles Buna, vice-président du Grand Lyon, en charge de l'urbanisme. "L'objectif, c'est de végétaliser l'ensemble des tours et des passerelles de la gare de Perrache, soit une surface de 2.000 m2 au total". |

| Le téléphone portable

est-il dangereux pour la santé? Une récente étude

vient de publier ses résultats: les chercheurs concluent qu'après

10 ans d'utilisation, le risque de développer une tumeur au cerveau

est double. Le Docteur Lennart Hardell de l'hôpital universitaire

d'Orebro en Suède précise que les risques majeurs se situent

sur le côté du crâne, à l'endroit où le

téléphone repose sur l'oreille.

Ces tumeurs au cerveau pourraient venir d'une exposition prolongée aux radiations électromagnétiques et sont d'autant plus difficiles à soigner qu'elles touchent le système nerveux. En effet, les amas de cellules grandissent à partir du nerf qui relie l'oreille au cerveau. Jusqu'à présent, les scientifiques n'avaient pas assez de recul pour pouvoir faire des études à long terme. Aujourd'hui, cela devient possible puisque selon les scientifiques «10 ans est une période minimum raisonnable» pour estimer les risques. |

Le Docteur Hardell et son équipe ont

synthétisé les résultats de 11 études évaluant

sur du long terme les risques de développer une tumeur cérébrale.

Seulement une étude sur les 11 a montré que l'utilisation

des téléphones mobiles n'augmente pas le risque de tumeur.

De manière générale, une tumeur cérébrale a plus de risques de se développer dans les zones du cerveau les plus exposées à une radiation chronique pendant une décennie. Les chercheurs responsables de l'étude concluent qu'il faut continuer d'étudier le risque de croissance tumorale alors que d'autres types de tumeurs dont les origines sont inconnues pourraient provenir de l'utilisation des téléphones portables. (Céline Soleille) |

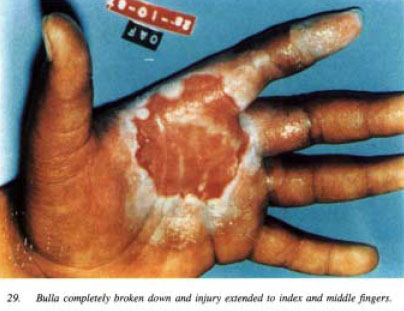

| Le 10-13 septembre 1987 à

Goiânia (Brésil), la dispersion d'une source médicale

de chlorure de césium 137, abandonnée en 1985 dans une clinique

désaffectée, a eu des conséquences très graves.

Le barillet de l'appareil d'irradiation, contenant la source radioactive, a été récupéré par deux ferrailleurs pères de famille qui l'ont rapporté chez eux. Les premiers signes d'irradiation globale et localisée, vomissements et diarrhées, sont apparus dès le lendemain chez ces deux ferrailleurs, suivis rapidement d'érythème des mains, d'autres membres des deux familles ont aussi souffert de troubles identiques. Ces ennuis de santé n'ont pas empêché les «bricoleurs» de cisailler le barillet, ce qui a entraîné la libération de la poudre de césium. Les troubles présentés par les deux chefs de famille ne faisant qu'empirer, ces derniers ont consulté un médecin qui a diagnostiqué une pathologie tropicale.  Cinq jours après la «récupération»

de la source (18 septembre), les premiers fragments ont été

vendus à des ferrailleurs. La dispersion de la source de césium

137 dans l'environnement immédiat des habitations a entraîné

des troubles digestifs chez les membres de nombreuses familles. Les enfants

ont été particulièrement atteints, car, après

avoir constaté la luminescence du produit, ils l'ont utilisé

pour leurs jeux et pour baliser les allées.

Six personnes ont été immédiatement évacués sur Rio de Janeiro, suivis par quatre autres le 3 octobre. A la mi-octobre, vingt personnes étaient hospitalisées, dont quatorze à Rio de Janeiro et six à Goiânia. Parmi ces vingt personnes, dix avaient reçu des doses comprises entre 300 et 700 rad et huit présentaient des signes graves d'un syndrome aigu d'irradiation (ce sont des doses du "genre" Hiroshima!). |

Les traitements n'ont pas pu empêcher

le décès de quatre personnes, pour lesquelles les doses reçues

ont été évaluées entre 450 et 600 rad (voir:

"Les effets du nucléaire sur le vivant" sur: http://www.dissident-media.org/infonucleaire/effets_vivant.html).

En outre, vingt-huit personnes ont souffert de brûlures, avec des lésions graves pour une dizaine d'entre eux, nécessitant des greffes et des amputations. La dispersion considérable de la poudre de césium a causé des contaminations internes (voies d'entrée cutanée et digestive) dont certaines correspondent à des doses très élevées. Pour effectuer les mesures des quantités de césium incorporées par chaque personnes, il a fallu construire un appareillage spécial, à cause de la saturation des appareils classiques destinés à la mesure de faibles quantités de radionucléides. Cette construction a pris un mois entier. En avril 1988, six cents personnes avaient été mesurées, parmi lesquelles quatre-vingt-sept avaient des charges corporelles de césium 137 correspondant chez trente adultes à des doses comprises entre 1 et 100 rad, et chez les enfants à des doses souvent supérieures (un enfant de six ans avait une dose engagée de 400 rad). Une première décontamination de l'environnement, qui a nécessité la destruction de maisons, n'a été achevée qu'après trois semaines de travaux, elle a nécessité le contrôle des maisons à un kilomètre à la ronde des lieux de l'accident et de 2.000 km de routes. D'octobre à décembre 1987, le bilan global a montré que quatre-vingt-cinq maisons étaient aussi contaminées, nécessitant l'évacuation de deux cents personnes. La ville et ses environs n'ont été considérés assainis "de façon acceptable" qu'en mars 1988. Les travaux d'assainissement ont généré d'énormes quantités de déchets, plus ou moins radioactifs, en raison d'un tri insuffisant. Un site d'entreposage a été créé à une trentaine de kilomètres de la ville, dans lequel 3.500 m3 de déchets ont été déposés, constitués de 12.500 fûts et 1.500 conteneurs. L'activité totale récupérée a été estimée à environ 85% de la source. Plus de dix ans ont été nécessaires pour que les autorités puissent trouver une solution de stockage définitif acceptable par les populations locales et régionales. L'impact de l'accident fut très lourd, et l'économie de toute la région a été affectée. Aux 4 décès rapides combien doit-on rajouter au bout de 20 ans de morts par leucémies ou par cancers chez ces plus de 1.000 victimes contaminées? En savoir plus:

|

| Le 14 septembre, les scientifiques

ont annoncé que le passage du Nord-Ouest, route maritime directe

entre l'Europe et l'Asie, est entièrement libre de glaces pour la

première fois depuis que des observations satellite ont débuté

en 1978. Ce passage à travers l'Arctique canadien constitue un raccourci

entre l'océan Atlantique et l'Océan pacifique et permettrait

aux navires, qui actuellement transitent par le canal de Suez ou le Canal

du Panama, d'économiser de manière significative temps et

carburants.

Les modèles climatiques prévoyaient que ce passage pourrait éventuellement s'ouvrir suite au réchauffement climatique qui fait fondre les glaces de l'Arctique, mais aucun n'imaginait que cet événement interviendrait si rapidement. A-t-on atteint le point critique où l'on bascule d'un changement progressif à une évolution rapide? |

Quoi qu'il en soit, cette brutale fonte des glaces intensifie

la bataille internationale pour le contrôle des routes et des ressources

naturelles ainsi libérées.

Il sera important de vérifier que ce passage s'ouvrira maintenant chaque année. Sources:

Voir aussi, Une expédition dans les glaces polaires:

|

| Les pesticides sont présents

dans l'air jusqu'au coeur de Paris et des villes qui l'entourent, selon

une première étude de la société Airparif sur

les traces de produits phytosanitaires dans l'air en Ile-de-France.

"Sur 80 pesticides recherchés, une trentaine ont été retrouvés en zone rurale et une vingtaine dans l'agglomération francilienne", conclut cette étude publiée jeudi qui confirme le caractère voyageur des composants, bien après leur application. Les mesures se sont déroulées au printemps 2006 sur cinq sites différents et ont donné lieu à plus de 5.200 analyses, souligne Airparif, qui surveille la qualité de l'air en Ile-de-France. Pour la première fois, Airparif s'intéresse à la pollution due aux pesticides, dont 3.200 tonnes environ sont employées chaque année dans la région pour des usages agricoles (48% du territoire régional est dévolu à l'agriculture) ou domestiques et urbains (jardins, parcs, voirie, cimetières...). Bien qu'il n'existe aucune obligation réglementaire de mesurer les pesticides dans l'atmopshère, l'étude a été commandée par la direction régionale des affaires sanitaires et sociales (Drass) dans le cadre du plan cancer et par les départements agricoles de Seine-et-Marne et du Val-d'Oise. |

Globalement, conclut Airparif, plus l'activité

agricole est importante, plus le nombre de pesticides retrouvés

dans l'air est élevé et les concentrations mesurées

sont plus faibles en agglomération qu'en zone très agricole,

comme la Beauce. Cependant, certaines molécules utilisées

spécifiquement dans les jardins vont se retrouver en concentrations

plus importantes en agglomération.

Par ailleurs, les composants retrouvés le plus fréquemment dans l'air ambiant - la trifluraline, le chlorothalonil et la pendiméthaline - ne sont pas nécessairement ceux retrouvés dans l'eau. Ainsi, certains produits comme le lindane (désormais interdit) persistent dans l'atmosphère alors que l'atrazine (interdite depuis 2003) persiste dans les eaux de surface, mais pas dans l'air. Enfin, selon les modes d'application, 25 à 75% des produits appliqués se retrouveraient dans l'atmosphère, soit au moment du traitement soit après, en se volatilisant. |

| A l'heure actuelle, les usines chimiques envoient leurs déchets vers différents traitements (incinération, enfouissement, vidange ou simple stockage) déplacant le problème d'un endroit à l'autre. La société israélienne EST (Environnemental Systems and Treaments) a développé en deux ans un appareil qui détruit quasi totalement les déchets, les convertissant en eau, CO2 et matériaux recyclable en industrie. | Ce système d'élimination est basé

sur un rayon plasmatronique à haute énergie. Il produit une

température de 2000 à 4500°C qui casse les liaisons moléculaires

des composés. Ces différents composés sont ensuite

rapidement refroidis et traités afin d'aboutir à des produits

gazeux non nocifs. Cette méthode détruit 99,99% des déchets

et peut être installée directement sur le site évitant

ainsi les problèmes de transport.

Source: Israel21c, 27/05/2007 |

Voici parmi ses propositions les principaux points de litige entre les participants au sommet, huit pays industrialisés (Allemagne, Grande-Bretagne, France, Italie, Etats-Unis, Canada, Japon, Russie) et cinq puissances émergentes (Chine, Inde, Brésil, Afrique du Sud, Mexique) d'après les déclarations de leurs dirigeants et des experts: - Réduction des émissions mondiales de CO2 (l'un des principaux gaz à effet de serre lié à l'usage des énergies fossiles) de moitié d'ici 2050 par rapport à 1990: Pour: Union européenne (Allemagne, GB, France, Italie), Japon (sans date de référence, pour son initiative Cool Earth 50), Canada, Chine. Contre: Etats-Unis, qui ont annoncé mercredi que le communiqué final ne comporterait pas d'engagements chiffrés. - Le seuil de 2°C de réchauffement "acceptable", adopté par l'UE sur la base des travaux scientifiques. Contre: Chine, Japon, Etats-Unis qui jugent la référence "inutile". "Elle sera très difficile à obtenir" lors du sommet du G8, reconnaît une source européenne. - Réaffirmation du rôle central de la Convention des Nations unies sur les changements climatiques (UNFCC) comme cadre des négociations de lutte contre le réchauffement: jugée cruciale par l'Allemagne, notamment pour les suites à donner au Protocole de Kyoto qui expire en 2012: Pour: UE, Japon, Brésil, Chine (les deux derniers, sans contraintes). Contre: Etats-Unis, qui n'ont pas ratifié Kyoto et ne font pas de l'Onu un cadre exclusif. Ils suggèrent un processus parallèle à celui de l'ONU avec la réunion des quinze principaux émetteurs à l'automne sur le mode du Partenariat Asie Pacifique sur le changement climatique qu'ils ont lancé en 2005 (AP6, avec Australie, Japon, Chine, Indonésie et Corée du Sud), sans engagements contraignants. - Mise en place d'un marché mondial du carbone donnant un prix à la "pollution": Pour: UE (le sien fonctionne depuis 2005; elle y voit le meilleur moyen d'inciter à la sobriété énergétique et au développement d'alternatives "propres"). |

Contre: contre Etats-Unis (puisqu'ils refusent la

contrainte d'objectifs de réduction des émissions) et misent

en priorité sur les futures technologies propres.

- Fixation d'objectifs globaux sur l'efficacité énergétique et la promotion des énergies alternatives au pétrole, gaz et charbon: Pour: UE, Japon, Chine. Contre: Etats-Unis qui considèrent que de tels objectifs relèvent des seuls gouvernements nationaux. Un sommet pour l'environnement très polluant http://www.bulletins-electroniques.com/actualites/43119.htm Entre le transport des nombreuses délégations,

et la foule de policiers et de journalistes, le sommet du G8 de Heiligendamm,

en partie consacré à la lutte contre le réchauffement

climatique, s'annonce très polluant. Au total 30.000 tonnes de gaz

carbonique seront relarguées dans l'atmosphère, affirme le

cabinet de conseil en entreprise munichois ClimatePartner cité

par le magazine allemand Spiegel.

Pour en savoir plus, contacts:

|

| La pollution de l'air en région

parisienne serait "largement sous-évaluée", selon

une étude publiée jeudi et transmise à l'AFP par l'association

Ecologie

sans frontière (ESF), qui met en cause l'insuffisance et l'obsolescence

des dispositifs d'alerte.

Les conclusions des travaux réalisés par le bureau d'études indépendant Horizons "confirment que la pollution de l'air de l'agglomération parisienne est encore largement sous-évaluée, et que les nouvelles connaissances scientifiques devancent les réglementations actuelles", affirme ESF. Selon cette étude, dévoilée jeudi par Le Parisien, l'air ambiant de la région parisienne est pollué par une "mixture de substances qui ne font pas toutes l'objet d'une règlementation", certains polluants étant "insuffisamment, voire pas du tout, surveillés". L'inventaire des polluants émis dans l'air ambiant serait "ancien, incomplet et incertain". Ainsi, "les impacts pourraient être sous-évalués concernant d'importantes sources de pollution de l'agglomération" comme le trafic routier, le trafic aérien et les grandes installations de combustion, met en garde ESF. Certains phénomènes comme les effets secondaires des technologies anti-pollution et la formation de polluants secondaires à partir de mélange de substances émis dans l'atmosphère seraient en outre "ignorés", selon l'étude. |

Par ailleurs, "l'information délivrée

en continu par le dispositif de surveillance renseigne peu sur la pollution

des sites à très forte fréquentation, notamment à

proximité du trafic automobile", déplore ESF dans une

synthèse des conclusions de l'étude.

Les sites de mesures servant de base aux indices ATMO (indices de qualité de l'air) "sont très peu représentatifs de l'exposition réelle de la population", affirme ESF. "Les risques encourus par la population sont totalement sous-évalués", alors qu'une "multiplication sensible des pics de pollution est à craindre", dénonce l'association. ESF, qui a lancé une pétition disponible sur son site web, réclame une série de mesures, comme la prise en compte de la station située sur le boulevard périphérique parisien dans le déclenchement des procédures d'alerte ou l'ouverture de nouvelles stations de mesure de la pollution liée au trafic automobile dans toute l'agglomération parisienne. Elle demande le lancement d'alertes spécifiques pour les populations vivant à proximité des axes de circulation, pour les automobilistes ainsi que la mise en place d'une information claire sur la pollution dans le métro parisien. Elle exige également que "cessent les zones de non-droit en matière d'analyse de pollution" que sont, selon elle, les aéroports et réclame l'installation de capteurs et de procédures d'alerte sur toutes les zones aéroportuaires pouvant conduire à une limitation, voire à une interdiction, du trafic aérien. |

| Climate – and not modern humans – was

the cause of the Neanderthal extinction in the Iberian Peninsula. Such

is the conclusion of the University of Granada research group RNM 179 -

Mineralogy and Geochemistry of sedimentary and metamorphic environments,

headed by professor Miguel Ortega Huertas and whose members Francisco José

Jiménez Espejo, Francisca Martínez Ruiz and David Gallego

Torres work jointly at the department of Mineralogy and Petrology of the

University of Granada (Universidad de Granada http://www.ugr.es)

and the Andalusian Regional Institute of Earth Sciences (CSIC-UGR).

Together with other scientists from the Gibraltar Museum, Stanford University and the Japan Marine Science & Technology Center (JAMSTEC), the Spanish scientists published in the scientific journal Quaternary Science Reviews an innovative work representing a considerable step forward in the knowledge of human ancestral history. The results of this multidisciplinary research are an important contribution to the understanding of the Neanderthal extinction and the colonisation of the European continent by Homo Sapiens. During the last Ice Age, the Iberian Peninsula was a refuge for Neanderthals, who had survived in local pockets during previous Ice Ages, bouncing back to Europe when weather conditions improved. |

Climate reconstructions

The study is based upon climate reconstructions elaborated from marine records and using the experience of Spanish and international research groups on Western Mediterranean paleoceanography. The conclusions point out that Neanderthal populations did suffer fluctuations related to climate changes before the first Homo Sapiens arrived in the Iberian Peninsula. Cold, arid and highly variable climate was the least favourable weather for Neanderthals and 24.000 years ago they had to face the worst weather conditions in the last 250.000 years. The most important about these data is that they differ from the current scientific paradigm which makes Homo Sapiens responsible for the Neanderthal extinction. This work is a contribution to a new scientific current – leaded by Dr. Clive Finlayson, from the Gibraltar Museum – according to which Neanderthal isolation and, possibly, extinction were due to environmental factors. These studies on climate variability are part of the work of the group RNM 179, funded by the excellence project RNM 0432 of the Andalusian Regional Government's Department for Innovation, Science and Business and by the MARCAL project of the Spanish Ministry of Education and Science, both linked to the Andalusian Environment Centre (CEAMA - Centro Andaluz de Medio Ambiente). |

| Le réchauffement climatique va-t-il,

entre autres conséquences, modifier la répartition géographique

des insectes servant de vecteurs à des maladies infectieuses? Le

paludisme pourrait-il réapparaître en Europe occidentale,

d'où il a disparu au XXe siècle ? Dans les pays en développement,

des régions jusque-là indemnes seront-elles touchées

par ces maladies?

Selon le récent rapport du Groupe d'experts intergouvernemental sur l'évolution du climat (GIEC), "les projections des changements climatiques affecteront probablement l'état de santé de millions de personnes, particulièrement celles à faible capacité d'adaptation". Parmi les mécanismes en cause, les experts pointent "la modification de la répartition spatiale de certains vecteurs de maladies infectieuses". Jusqu'à l'épidémie de chikungunya qui a frappé en 2006 l'océan Indien, et notamment l'île de La Réunion, la renommée du moustique Aedes albopictus ne dépassait pas le cercle des entomologistes. Ceux-ci considéraient d'ailleurs qu'il n'était pas le meilleur vecteur des arbovirus - ensemble de virus transmis par des moustiques ou des tiques, comme le chikungunya. Avant 1980, A. albopictus était présent en Asie du Sud et du Sud-Est, au Japon et dans l'océan Indien. Depuis 1980, il s'est étendu à la Chine, à l'Océanie, au bassin méditerranéen - sud de la France compris -, en Afrique (Nigeria et Cameroun) et à une partie du continent américain, dont les Etats-Unis. L'équipe de Didier Raoult (CHU La Timone, Marseille) indiquait, dans le New England Journal of Medicine du 22 février, qu'à l'image de l'émergence en 1999 du virus West Nile aux Etats-Unis, "le virus chikungunya pourrait s'établir dans n'importe laquelle des zones tropicales ou tempérées où A. albopictus est présent aujourd'hui, ou dans celle où il migre". Simon Hales et ses collègues de la faculté de médecine de Wellington (Nouvelle-Zélande) ont réalisé une modélisation de la dengue, maladie virale transmise par un vecteur la plus répandue au monde, pour laquelle il n'existe ni traitement efficace, ni vaccin. En 1990, près de 30% de la population mondiale vivaient dans une région où le risque de transmission de la dengue était de 50%. En 2085, avec les modifications prévisibles touchant les populations et le climat, plus de la moitié des habitants de la planète, soit 5 à 6 milliards d'individus, seraient exposés au risque de dengue, contre 35% si le climat ne se modifiait pas. |

Depuis les années 1970, le paludisme s'est

largement développé dans une grande ville comme Nairobi (Kenya),

pourtant située à plus de 1.600 m d'altitude. A quoi faut-il

attribuer cette extension vers des zones habituellement exemptes et dont

les habitants ne sont que faiblement immunisés contre elle? Est-elle

imputable au réchauffement climatique ou à d'autres facteurs

- insuffisance des campagnes de démoustication, apparition de moustiques

résistant aux insecticides ou mouvements de population? Toute la

difficulté réside dans l'incapacité à différencier

ces différents paramètres qui, de plus, ne s'excluent pas.

Jean-Pierre Besancenot, du Centre de recherches de climatologie à l'université de Bourgogne, écrivait en 2000: "Si en 1990, 45% de l'humanité vivaient dans des régions où sévit le paludisme, le taux pourrait atteindre 60 % dans un demi-siècle, du double fait de l'élargissement de la zone impaludée et de sa forte croissance démographique." En 2001, dans le Bulletin de l'Organisation mondiale de la santé (OMS), quatre experts passaient en revue l'impact du changement climatique sur les maladies à transmission vectorielle. Soulignant la différence entre les variations du climat au fil des saisons et l'évolution des tendances de fond, ils se gardaient de conclure hâtivement: "Alors que l'impact de la variabilité climatique sur les maladies à transmission vectorielle est relativement facile à déceler, il n'en est pas de même des modifications à long terme du climat, beaucoup plus lentes. Il est possible que les populations humaines s'adaptent à ces modifications pour en réduire l'impact. Par exemple, sur les hauts plateaux africains, le paludisme pourrait progressivement se stabiliser, ce qui conduirait à une diminution des épidémies." Entomologiste médical et spécialiste de la dengue, Paul Reiter (Institut Pasteur, Paris) est plus sceptique que d'autres experts sur l'impact du changement climatique. Il ne le conteste pas, mais il regrette des "positions militantes". Il met en avant le fait que le virus ou le parasite, le vecteur et l'homme, sans oublier un éventuel réservoir animal, forment un système complexe où les interactions sont nombreuses et les équilibres instables. L'augmentation de la température peut avoir localement des effets paradoxaux : augmenter le taux de transmission de l'agent infectieux par son vecteur ou diminuer le taux de survie de ce vecteur. Les divergences des experts n'empêchent pas qu'ils s'accordent sur le fait que l'ensemble des activités humaines a des répercussions sur les maladies infectieuses transmises par des vecteurs. Certaines par le biais du climat, ce dernier n'étant pas l'unique paramètre. Paul Benkimoun

|

· Sources ADIT:

· · La

canicule de l'été 2003 a fait plus de 70.000 morts en Europe,

selon l'Inserm (LEMONDE.FR

avec AFP et Reuters | 23.03.07):

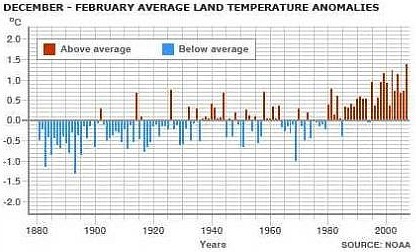

| Les températures mondiales enregistrées

entre décembre et février ont été les plus

élevées jamais répertoriées à cette

période de l'année, avec une température moyenne supérieure

de 0,72°C à la moyenne du XXe siècle, selon l'Administration

américaine océanique et atmosphérique (NOAA).

Il s'agit de la température moyenne la plus haute jamais enregistrée depuis que les relevés systématiques ont débuté, en 1880, en raison notamment d'un mois de janvier exceptionnellement chaud au niveau mondial, précise la NOAA. La NOAA ne conclut toutefois pas que les émissions de gaz à effet de serre soient à l'origine de cette hausse des températures. Pour Jay Lawrimore, responsable du centre national de données climatiques au sein de la NOAA, "les facteurs qui ont contribué [à cette hausse des températures] sont une tendance à long terme au réchauffement ainsi qu'un El Nino modéré dans le Pacifique." En janvier, les températures mondiales, à la fois terrestres et océaniques, constatées par la NOAA ont été les plus élevées jamais répertoriées. |

De décembre à février, la moyenne des températures

océaniques est la deuxième plus haute jamais enregistrée,

soit 0,06°C en dessous du record établi en 1998, au plus fort

du phénomène El Nino.

Les scientifiques de la NOAA soulignent par ailleurs une accélération de la hausse des températures. Au siècle dernier, les températures mondiales ont progressé à un rythme de 0,06°C tous les dix ans."Mais ce taux de progression a été trois fois plus élevé depuis 1976, soit 0,18 degré tous les dix ans, avec certaines des plus fortes augmentations de températures intervenues dans les latitudes élevées de l'hémisphère Nord", près du pôle Nord, ajoute la NOAA. Début février, le quatrième rapport scientifique du Groupe intergouvernemental d'experts sur l'évolution du climat (GIEC) a, pour sa part, souligné que les émissions de gaz à effet de serre dues à l'activité humaine risquent de causer de graves dérèglements climatiques, avec un réchauffement qui pourrait aller jusqu'à + 4°C d'ici à la fin du siècle et une hausse du niveau des mers jusqu'à 58 cm. |

| Une petite île de l'archipel des

Canaries, El Hierro, va devenir la première île au monde à

être alimentée à 100% par des énergies renouvelables,

a assuré mardi le gouvernement espagnol.

Le ministère de l'Industrie a annoncé qu'El Hierro, île volcanique de 278 km2 peuplée de 10.500 habitants, serait alimentée entièrement en électricité par une combinaison d'éoliennes et d'hydroélectricité. "El Hierro sera la première île au monde alimentée à 100% par des énergies renouvelables", a-t-il affirmé dans un communiqué. Le système mis en place comprendra une centrale hydroélectrique alimentée par deux réservoirs, un parc éolien et un système de pompage. "La plus grande partie de l'énergie injectée dans le réseau de distribution proviendra de la centrale hydro-électrique", d'une capacité de 10 MW, selon le communiqué. "La majorité de l'énergie produite par les éoliennes servira à alimenter le système de pompage" pour stocker l'eau dans un des deux réservoirs, "sous forme d'énergie potentielle", ajoute-t-il. |

L'excédent d'énergie éolienne

servira à alimenter deux usines de désalinisation d'eau

de mer.

Une centrale conventionnelle, préexistante, fonctionnant au diesel, sera maintenue pour les cas d'urgence en cas de manque d'eau et de vent. "Par ce système, nous parvenons à transformer une source d'énergie intermittente en un approvisionnement contrôlé et constant d'électricité", s'est réjoui le ministère. Le système représentera un investissement de 54,3 millions €, étalé jusqu'en 2009, et permettra d'éviter l'émission des 18.700 tonnes de CO2 par an actuellement rejetées par la centrale thermique locale. L'Espagne est un des leaders européens de l'énergie éolienne. Elle a enregistré lundi son record de production éolienne: les forts vents qui ont soufflé sur le pays ont permis aux moulins de fournir 27% de la demande électrique du pays. |

"Mauvaise planification et protection inadaptée des zones naturelles, ne nous permettent plus d'être sûrs que l'eau des fleuves continuera de couler", avertit le rapport du WWF publié à l'occasion de la Journée mondiale de l'eau, le 22 mars. Si rien n'est fait, "il y aura de plus en plus de conflits pour avoir accès à l'eau", prévient Jamie Pittock, directeur du Programme global du WWF pour l'eau douce. Le pompage excessif de leurs eaux pour l'agriculture et la consommation humaine "menace de mettre complètement à sec le Rio Grande et le Gange", s'alarme le WWF. L'Indus, déjà victime de prélèvements excessifs, est menacé par le réchauffement climatique en raison de sa dépendance des eaux provenant des glaciers himalayens en déclin. De même, la hausse des températures a "potentiellement des effets dévastateurs pour la pêche, la ressource en eau et la paix dans la région africaine aride du Nil-Lac Victoria", avertit encore le WWF. Le Mékong est victime de la pêche excessive tandis que le Yangtzé est asphyxié par la pollution provoquée notamment par l'industrialisation massive le long de ses rives. |

Pour le Rio de La Plata, le Danube et la Salouen

(un fleuve qui prend sa source au Tibet et se jette dans la mer en Birmanie),

ce sont les barrages et les projets d'infrastructure pour la navigation

qui font planer le plus grand danger sur les ressources en eau douce.

L'organisation de défense de la nature conseille d'étudier avec soin la situation avant de se lancer dans des travaux d'infrastucture et suggère par exemple de préférer le transport par rail au développement de la navigation sur le Danube. "Comme les gouvernements s'inquiètent maintenant de la diminution des ressources en eau à cause du changement climatique ils construisent de plus en plus de barrages pour en stocker davantage, ce qui a pour résultat de prélever encore plus d'eau des rivières et de créer encore plus de problèmes écologiques", avertit M. Pittock. De même, "beaucoup de gouvernements veulent construire des centrales hydro-électriques comme sources d'énergie propre, ce qui, une fois encore bloque les cours d'eau et tue les poissons", poursuit-il. En Australie, ce sont des espèces introduites par l'homme qui ont envahi le fleuve Murray-Darling, où les espèces indigènes ne représentent plus que 10% de la faune aquatique. La consommation globale d'eau douce augmente deux fois plus vite que la population, ce qui signifie qu'en 2025 plus de 60% des hommes vivront dans des régions souffrant de pénuries d'eau significatives, selon les estimations de l'Institut de Stockholm pour l'environnement. "La crise va bien au delà des dix fleuves étudiés mais le rapport reflète à quel point le développement sans frein menace la capacité de la nature à satisfaire notre demande croissante", remarque M. Pittock. |

| Munis de masques et de bouteilles d'oxygène,

les secouristes russes continuent inlassablement de descendre dans la mine

de Kemerovo pour extirper les derniers mineurs, morts ou vivants, au lendemain

du coup de grisou qui a tué au moins 106 personnes. Il s'agit de

l'un des accidents miniers les plus meurtriers en Russie depuis la chute

de l'URSS.

Vingt-quatre heures après l'explosion, une épaisse fumée s'échappait toujours de la mine. Et des explosions, provoquées par les artificiers pour faciliter la progression des secouristes, retentissaient régulièrement. Nous espérons trouver d'autres personnes vivantes, a assuré le ministre des Situations d'urgence Sergueï Choïgou dans la matinée. Selon une porte-parole du ministère des Situations d'urgence jointe par téléphone à Moscou, 106 personnes ont été tuées, 93 ont été sauvées. Quatre mineurs, morts ou vivants, n'ont pas encore été retrouvés. Les recherches sont très difficiles, selon Sergueï Cheremnov, le porte-parole du gouverneur de la région minière de Kemerovo. Il y a une mauvaise ventilation, une inondation et énormément de destruction, déplore le porte-parole. Un responsable locale du ministère des Situations d'urgence, Guennadi Melnikov a décrit un véritable carnage par moins 270 mètres, la profondeur de la mine. Nous avons travaillé toute la nuit. C'était horrible, beaucoup de personnes sont mortes. Et les corps que nous remontions étaient complètement démembrés, dit-il. Les familles des mineurs disparus n'ont pas été autorisées à se rendre sur le site et ont été rassemblées à soixante kilomètres de là dans une autre mine où des psychologues les ont prises en charge. L'identification des corps aura également lieu dans cette autre mine. |

Exploitée par la société Ioujkouzbassougol

qui en possède une douzaine dans la région, la mine de charbon

était dotée d'équipements dernier cri et se voulait

la vitrine de son propriétaire avant une introduction en bourse

dès cette année. Ioujkouzbassougol est contrôlé

par le géant russe de l'acier Evraz, propriété à

41% du richissime homme d'affaires russe Roman Abramovitch.

La quasi-totalité de la direction est morte dans l'accident, a indiqué le gouverneur de la région Aman Touleïev, précisant que 20 hauts responsables se trouvaient au fond de la mine et sont morts lors de la catastrophe. Seul le directeur de la mine, qui était en vacances, en a réchappé. Un Britannique, employé par la société de consulting minière IMC, est également mort dans l'accident. Selon l'administration locale, environ 200 personnes se trouvaient dans la mine au moment de l'explosion. Pour le gouverneur de la région, Aman Touleïev, l'accident a pu être provoqué par un "éboulement" de charbon qui aurait entraîné un effondrement d'une des galeries. Et le méthane s'est ensuite concentré dans certaines parties de la mine, prêt à exploser. Novokouznetsk, où est située la mine, est à 180 km de Kemerovo. Cette ville est elle-même située à 3.000 km à l'est de Moscou. Sur les dix dernières années, c'est le sixième accident de ce type dans la région de Kemerovo qui compte de nombreuses mines. En 1997, l'incident le plus meurtrier avait causé la mort de 67 mineurs. Vingt-trois mineurs avaient été tués dans un coup de grisou en 2005. En 2004, deux explosions dans deux endroits distincts avaient causé la mort de 60 mineurs au total. |

| Les températures mondiales enregistrées

en janvier ont été les plus élevées jamais

constatées à cette période de l'année, ont

annoncé vendredi les scientifiques de l'Administration américaine

océanique et atmosphérique (NOAA).

"Les températures mondiales à la fois terrestres et à la surface des océans étaient les plus élevées enregistrées pour un mois de janvier", indique le NOAA dans un communiqué, citant des scientifiques de son Centre de données climatiques. Les températures mondiales, à la fois terrestres et océaniques, étaient en janvier 0,85 degré celsius au-dessus de la moyenne du 20e siècle, selon des données préliminaires, et ont ainsi surpassé le record établi en 2002 (0,71°C au-dessus de la moyenne). |

Dans le détail, les températures terrestres

étaient 1,89 degré celsius au-dessus de leur moyenne en janvier,

soit à un niveau record, tandis que les températures océaniques

étaient les quatrièmes plus chaudes jamais enregistrées

en 128 ans, soit 0,1 degré en-dessous du record établi en

1998 au plus fort du phénomène El Nino.

"La présence d'El Nino ainsi que la tendance continue au réchauffement climatique" ont contribué à faire du mois de janvier 2007 le plus chaud jamais connu, explique l'administration américaine dans son communiqué. Ces températures anormalement élevées ont aussi engendré les chutes de neige les deuxièmes plus faibles sur le continent eurasiatique. "Durant le siècle passé, les températures mondiales en surface ont progressé à un rythme de 0,06 degré celsius tous les 10 ans, mais le taux d'augmentation a été trois fois plus élevé depuis 1976, soit 0,18 degré tous les 10 ans, avec certaines des plus fortes augmentations de températures intervenues dans les latitudes élevées de l'hémisphère nord", soit près du pôle nord, a ajouté le NOAA. |

| Paris, le 09 mars 2007 : Travaillant

dans le cadre d'un programme de recherche lancé par le Ministère

de la recherche en juillet 2004, une équipe de chercheurs de l'Université

de Clermont-Ferrand vient de mettre en évidence les effets du rayonnement

des champs électromagnétiques de 900 MHz (la fréquence

la plus utilisée par la téléphonie mobile) sur le

fonctionnement génétique des végétaux (tomates).

Les chercheurs ont démontré qu'à des valeurs de champ de 5 v/m, très inférieures aux normes réglementaires actuelles (41 v/m et plus selon les fréquences utilisées)et, à l'issue d'une courte exposition (5 à 15 minutes), on observe des effets biochimiques comparables à ceux que l'on observe à la suite d'un choc ou d'une blessure. Les résultats de cette recherche «permettent d'établir un lien formel entre ces rayonnements électromagnétiques et une réponse physiologique immédiate, éliminant toute ambiguïté liée à l'intervention de facteurs externes à l'expérience ou de paramètres subjectifs difficiles à contrôler.» |

Il s'agit là d'une preuve importante de plus

de l'effet génotoxique des rayonnements de la téléphonie

mobile. Elle vient compléter et conforter les résultats de

plusieurs autres recherches fondées sur des cellules animales

et humaines, parmi lesquelles on peut citer, notamment, les résultats

du programme européen REFLEX et ceux d'autres études récentes,

américaine et indienne notamment.

Ces résultats devraient mettre un terme définitif aux interprétations hâtives, émises par certains experts officiels, sur le caractère psychosomatique des maux dont se plaignent de nombreux riverains d'antennes-relais. Ces recherches sont des signaux d'alerte qui doivent conduire les autorités publiques à la plus grande prudence. Une politique de gestion de risques doit enfin être mise en ouvre. Face à l'absence chronique du premier Ministre, au silence assourdissant du ministre de la Santé et au désintérêt manifeste de le ministre de l'Ecologie, Priartém et Agir pour l'Environnement ont décidé d'interpeller les candidats à l'élection présidentielle! |

| Selon une étude publiée

dans Environmental science and technology, la concentration en antimoine

dans l'eau minérale augmente avec la durée de

conservation dans les bouteilles en plastique. Des chercheurs de l'université de Heidelberg en Allemagne ont mesuré la quantité de ce métal, dont le caractère cancérogène est suspecté, au niveau de 15 marques d'eau en bouteille canadiennes, et de 48 marques européennes (1). Ils ont observé une augmentation de la concentration moyenne au bout de 6 mois de conservation (+19% pour les bouteilles canadiennes et +90% pour les bouteilles européennes), sachant que les concentrations varient selon la marque de l'eau. Les quantités d'antimoine détectées sont toutefois nettement inférieures aux normes concernant l'eau potable, excepté pour deux des marques qui présentent des niveaux supérieurs ou égaux au niveau maximum d'acceptabilité japonais, la norme la plus basse dans le monde. La majorité des bouteilles testées sont en polyéthylène téréphtalate (PET). «Ce qui est clair, c'est que l'eau qui se trouve dans des bouteilles en PET contient beaucoup plus d'antimoine que l'eau potable qui sort du robinet. Ce qui n'est pas clair, ce sont les conséquences pour la santé humaine», a indiqué le responsable de l'étude William Shotyk. |

(1) Précédent article du JDLE sur ce sujet:

«Un métal toxique dans les bouteilles d'eau»

16/03/2006, par Claire Avignon:

Selon des chercheurs de l'université d'Heidelberg (Allemagne), les bouteilles d'eau en polyéthylène téréphtalate (PET) contiennent des traces d'antimoine (Sb), une substance toxique. Les scientifiques allemands ont étudié 15 marques canadiennes d'eau vendue en bouteille de PET, et 48 marques européennes. Pour comparaison, ils ont aussi mesuré la teneur en antimoine d'une eau provenant d'une nappe phréatique canadienne, 3 marques d'eau déionisée conditionnée dans des bouteilles en PET et une marque d'eau canadienne emballée dans du polypropylène. L'antimoine a été détecté à hauteur de centaines de parties par trillion (ppt), soit beaucoup plus que pour les autres types d'eau, et notamment l'eau provenant de la bouteille en polypropylène. Ce qui a confirmé l'hypothèse de l'équipe universitaire: le métal toxique provient du PET, dont un de ses composés, le trioxyde de diantimoine, est utilisé dans la fabrication de ce type de plastique. D'ailleurs, les chercheurs ont poussé leur expérience jusqu'à mesurer le taux d'antimoine dans une eau habituellement conditionnée dans du PET, avant son emballage. Là encore, l'eau avait une teneur beaucoup plus faible qu'après cette étape industrielle: 4 ppt, contre 360 ppt juste après le conditionnement, et 630 ppt 3 mois plus tard. La teneur en antimoine reste bien inférieure aux recommandations, mais sa consommation continue peut devenir gênante. D'autant plus, note William Shotyk, qu'«au Japon, le PET est fabriqué avec du titane (Ti), un élément insoluble et sans danger, contrairement à l'antimoine.» |

| Les années se suivent, les "anomalies

chaudes" s'accumulent. Selon l'Organisation météorologique

mondiale (OMM), l'année 2006 est la sixième année

la plus chaude enregistrée depuis 1861, avec une température

moyenne à la surface du globe excédant de 0,42°C la moyenne

calculée entre 1961 et 1990. Les deux plus chaudes jamais relevées

demeurent 1998 (+ 0,54°C) et 2005 (+ 0,48°C). Viennent ensuite,

par ordre décroissant, les années 2002, 2003 et 2004..

Sur le territoire français, 2006 est, selon Météo France, la deuxième année la plus chaude, après 2003, enregistrée depuis 1950, avec un écart à la moyenne compris entre + 1,2°C et + 1,3°C. Cette anomalie de température est principalement liée à l'automne exceptionnellement doux qui a prévalu sur l'ensemble de l'Europe occidentale - excédant de 3°C environ les normales saisonnières -, ainsi qu'au mois de juillet. Tous mois confondus, celui-ci a été le deuxième à s'éloigner le plus des moyennes depuis un demi-siècle, derrière le caniculaire mois d'août 2003. Sur les cinq continents, les événements extrêmes se sont multipliés. Pour l'OMM, le début de l'année a été "inhabituellement doux sur une grande part de l'Amérique du Nord et sur les îles arctiques européennes", alors que "l'Asie, la Russie et l'Europe orientale connaissaient de rudes conditions hivernales". Les anomalies chaudes les plus importantes ont été relevées sur l'île norvégienne du Spitzberg. |

La douceur inhabituelle qui a prévalu

sur l'Arctique a eu une forte influence sur les glaces de mer. Au mois

de septembre, la banquise occupait une superficie de seulement 5,9 millions

de km2, la deuxième plus faible mesurée en cette

saison, après 2005.

L'hémisphère sud a connu, lui aussi, plusieurs événements records. Des "chaleurs extrêmes et persistantes" ont été notées de décembre 2005 à mars sur une grande part de l'Australie orientale. Sur la grande île, le printemps (de septembre à novembre) a été le plus chaud jamais enregistré depuis le début des mesures en 1950. De même, au Brésil, entre janvier et mars, la température a frôlé les 45°C - l'une des plus élevées jamais mesurées dans ce pays. L'Afrique australe a connu des conditions pluviométriques satisfaisantes au cours du premier trimestre. Plus tard, en octobre et novembre, la Corne de l'Afrique a subi des pluies torrentielles, les plus sévères enregistrées depuis cinquante ans. Ces précipitations violentes ont suivi une longue période de sécheresse et, explique l'OMM, "les sols desséchés n'ont pas été capables d'en absorber de grandes quantités". Stéphane Foucart

|

| La température moyenne à

l'échelle mondiale pourrait atteindre un niveau record en 2007 pour

se situer à 14,54°C, détrônant ainsi l'année

1998, selon les services météorologiques britanniques.

"La température mondiale en 2007 devrait être de 0,54°C au-dessus de la moyenne long terme (1961-1990) de 14,0°C", a indiqué jeudi l'organisme météorologique dans un communiqué. "Il y a 60% de probabilité que 2007 soit aussi chaude ou plus chaude que la plus chaude actuellement", a-t-il ajouté. Le record remonte à 1998, lorsque la température avait dépassé de 0,52 degré la moyenne long terme. Au cours des sept dernières années, les prévisions annuelles de température de la planète effectuées par la météo britannique ont été "remarquablement précises" avec une marge d'erreur de seulement 0,06°C. |

"Il y a 95% de chances que la température

se situe entre 0,38 et 0,70°C au-dessus de la normale",

ont souligné les services britanniques.

"Le record potentiel de 2007 découle en partie de l'intensité modérée d'El Nino qui s'est déjà installé dans le Pacifique, et qui devrait persister au cours des premiers mois de 2007", ont-ils ajouté. Ce phénomène climatique est lié à un réchauffement des eaux du centre et de l'est de l'Océan Pacifique, perturbant le climat des côtes occidentales de l'Amérique latine à l'Afrique de l'Est, et peut avoir une influence sur le climat mondial. Le Royaume-Uni a déjà enregistré pour sa part un record de température en 2006 avec une moyenne de 9,7°C, soit 1,1°C de plus que la moyenne de long terme. |

| Le déclin de la dynastie Tang,

l'une des plus importantes de l'histoire de la Chine, tout comme celui

de la civilisation classique maya, en Amérique centrale, pourraient

résider dans des changements dans les moussons en Asie, selon les

auteurs d'une étude publiée dans la revue Nature de

jeudi.

En effet, soulignent les auteurs de cette étude internationale qui ont travaillé sous la direction de Gerald Haug, du Centre de recherches sur la Terre (GeoforschungsZentrum) à Potsdam (Allemagne), l'écroulement de ces deux grandes cultures coïncide avec des modifications de ce cycle climatique, survenu entre l'an 700 et l'an 900 de notre ère. La sécheresse provoquée par ces bouleversements dans le régime des pluies, avec des baisses catastrophiques de récoltes et un appauvrissement quasi général, pourraient expliquer les tensions profondes qui ont abouti à l'effondrement des sociétés en place. Les scientifiques tirent leur conclusion de l'analyse de sédiments du lac Huguang Maar, dans le sud-est côtier de la Chine. |

Leurs propriétés magnétiques et leur teneur en

titane, expliquent-ils, fournissent des indications sur la force des moussons

en Asie de l'Est. Ces vents périodiques soufflent en hiver vers

la mer (mousson sèche) et en été vers la terre (mousson

humide).

Gerald Haug et ses collègues chinois et américains ont constaté qu'au cours des 16.000 dernières années, il y avait eu trois périodes où la mousson d'hiver était forte et le climat sec en Chine, notamment au moment du déclin de la treizième dynastie chinoise, celle des Tang, qui a régné de 618 à 907. Au bout de trois siècles de rayonnement, cette dynastie, célèbre pour ses arts et ses échanges commerciaux avec l'Inde et le Moyen-Orient, a sombré dans une révolte générale. Aux yeux des chercheurs, les variations dans la ceinture de pluies tropicales pourraient avoir été globales et expliquer donc aussi, du moins partiellement, la fin de l'ère classique maya (250-900) dans l'actuel Mexique et au Guatemala. Connue pour ses cités-états, son écriture hiéroglyphique, ses arts décoratifs, son calendrier solaire de 365 jours et ses pyramides, cette grande civilisation s'est effondrée brusquement en plein âge d'or. |

| Les scientifiques vont désormais

pouvoir retracer l'impact des éruptions volcaniques cataclysmiques

sur le climat de notre planète en étudiant leurs débris

piégés dans les glaces depuis des milliers d'années,

selon une étude à paraître dans la revue américaine

Science.

Lors d'éruptions majeures, comme celles du Vésuve en Italie (79), du Krakatoa en Indonésie (1883), ou du Pinatubo aux Philippines (1991), des cendres sont projetées dans la stratosphère, à plus de 11 kilomètres d'altitude. Le nuage causé par l'éruption réduit l'ensoleillement pendant des mois, provoquant une chute significative des températures. Des éruptions de moindre importance sont en revanche sans influence sur le climat, explique le Centre national de la recherche scientifique, dont le Laboratoire de glaciologie et géophysique de l'environnement (Grenoble) est co-signataire de l'article. Les poussières finissent par retomber sur de vastes étendues de notre Terre. Certaines sont demeurées intactes pendant des millénaires, piégées dans les glaces de l'Antarctique et du Groenland. |

Pour les scientifiques, on peut en déduire

l'impact des volcans sur le climat de notre planète au cours des

100.000 dernières années... à condition de pouvoir

distinguer entre les poussières produites par des éruptions

stratosphériques et les poussières générées

par de petits volcans voisins.

Les scientifiques français, associés à l'équipe de Mark Thiemens (Université de Californie), sont parvenus à distinguer ces deux types de volcanisme en étudiant la composition isotopique du soufre rejeté par les éruptions. Le soufre projeté dans la haute atmosphère est en effet modifié lors de son exposition aux rayons ultraviolets, ont découvert les scientifiques après avoir analysé des échantillons de glace de l'Antarctique conservant les retombées des deux éruptions volcaniques les plus violentes du 20ème siècle: celle du Pinatubo et celle du mont Agung (Indonésie), en 1963. "Il devient ainsi possible de déterminer la portée climatique d'une éruption à partir uniquement des enregistrements glaciaires et donc d'étendre cette étude à des périodes passées pour lesquelles aucune information précise sur les volcans n'est disponible", commente le CNRS dans son communiqué. |